Depuis que les modèles LLM ont commencé à crawler massivement le web, une question taraude les éditeurs : comment reprendre la main sur leurs contenus ? Pour l’instant, la réponse tient en un fichier texte : LLMs.txt.

Imaginé par Jeremy Howard (fast.ai), ce fichier est censé jouer le rôle d’un robots.txt, mais pour les modèles d’entraînement des IA. Il suffit de le placer à la racine d’un site pour y spécifier ce que les IA peuvent ou non utiliser Simple, clair, élégant… sur le papier en tout cas.

Mais dans la pratique ? L’adoption de cette « norme » reste marginale, même dans les milieux technophiles.

LLMs.txt boudé par les acteurs de la tech

L’enthousiasme initial provoqué par la création du LLMs.txt s’est vite dissipé. Malgré une médiatisation rapide dans la sphère tech, le fichier est loin de rencontrer le succès escompté. Ni OpenAI, ni Anthropic, ni Google ne semblent vouloir se conformer aux directives proposées par Jeremy Howard.

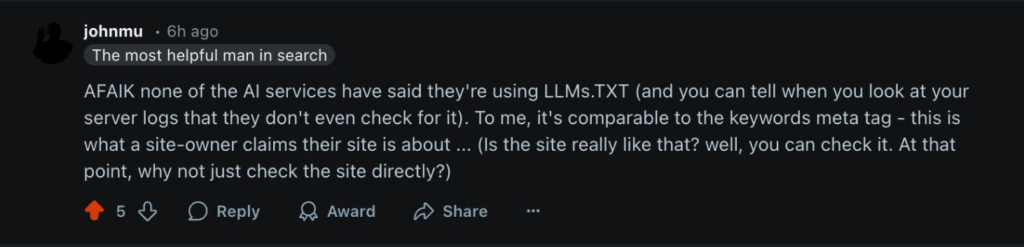

Ces dernières semaines, les critiques de la norme n’ont pas manqué de se faire entendre. John Mueller, Search Advocate chez Google, l’a ainsi récemment comparé à la balise meta keywords1. En d’autres termes, à une pratique désuète, dont personne ne devrait se soucier.

Bon à savoir : La balise meta keywords permettait autrefois d’indiquer les mots-clés ciblés par une page aux moteurs de recherche. Google l’ayant abandonnée depuis 2009, elle n’influence plus du tout le référencement. Inutile donc de la remplir, elle ne sert qu’à alourdir votre code.

Dans la communauté SEO, le doute s’installe

Côté SEO, l’accueil réservé au LLMs.txt oscille entre curiosité et scepticisme. Sur Reddit, plusieurs utilisateurs rapportent avoir mis en place le fichier sans constater le moindre changement dans le comportement des bots.

C’est par exemple le cas Simone De Palma, spécialiste du SEO technique chez Omnicom Media Group.

Salut,

J’ai déposé un fichier

LLM.txtà la racine de mon blog plus tôt ce mois-ci, mais je ne vois aucun impact dans mes logs de crawl pour le moment. Je me demandais si quelqu’un avait mis en place un système de suivi, ou simplement remarqué le moindre signe d’activité depuis la mise en place du fichier.Et si vous ne l’avez pas encore testé de votre côté, je serais curieux d’avoir vos retours à ce sujet.

Merci2 !

Mike Friedman relève quant à lui un autre problème potentiel. En renvoyant vers un simple fichier texte brut, le format Markdown imposé par LLMs.txt pourrait nuire à l’expérience utilisateur :

Le principal problème avec ces fichiers, c’est qu’ils ne contiennent aucune référence ou norme adoptée permettant de renvoyer vers les URL d’origine. Donc, si un modèle de langage (LLM) cite une de vos pages comme source, le lien pointera vers le fichier

.md, qui n’est qu’un bloc de texte brut. Et si un utilisateur clique dessus, l’expérience sera très mauvaise3.Quelqu’un a parlé de douche froide ?

Pourquoi le fichier LLMs.txt ne convainc pas ?

Sur le papier, le LLMs.txt semblait pourtant prometteur. Comment expliquer ce désaveu de la part de la communauté tech ? 3 freins majeurs empêchent l’adoption de la norme à grande échelle.

1. Pas de règle officielle, pas d’obligation

Contrairement au robots.txt, qui s’appuie sur des standards reconnus par les organismes techniques, la mise en place du LLMs.txt repose uniquement sur la bonne volonté des développeurs d’IA.

Rien ne les oblige ni à le lire ni à le respecter. Le fichier LLM reste une simple suggestion technique, pas une règle à respecter sous peine de sanction.

2. Risque de « double discours »

En proposant une version modifiée de la page aux agents IA, le fichier introduit une zone grise : celle du cloaking. Cela soulève plusieurs problèmes, notamment en matière de transparence, de fiabilité des algorithmes et d’intégrité de l’information sur le web.

Bon à savoir : En SEO, le cloaking désigne le fait de montrer un contenu différents aux moteurs de recherche et aux utilisateurs humains. Autrement dit : ce que voit Google n’est pas ce que voit l’internaute.

3. Trop compliqué à mettre en place pour beaucoup

Le LLMs.txt nécessite de créer et de maintenir des versions Markdown séparées des pages web, plus simples à lire pour les IA. Pour beaucoup de sites , cela représente une charge technique lourde, sans garantie de retour sur investissement.

Le LLMs.txt illustre bien l’état du web face aux IA en 2025 : des tentatives isolées pour freiner un phénomène global. Les éditeurs cherchent à protéger leurs contenus. Les IA, elles, continuent de collecter, d’ingérer et d’exploiter des informations, souvent sans autorisation ni transparence.

L’avenir du fichier, ou d’un successeur plus abouti, ne pourra se dessiner qu’à une condition : la mise en place de standards portés par une autorité de régulation forte. Sans cadre juridique clair, cette protection restera symbolique. Et le déséquilibre entre créateurs de contenu et exploitants de données continuera de se creuser.